Nvidia đã hoàn toàn thống trị thị trường chip AI khi chuyển đổi mục đích sử dụng của các thiết bị bán dẫn ban đầu được thiết kế cho trò chơi điện tử. Giờ đây, Grog, công ty khởi nghiệp nhỏ bé tám năm tuổi, tin rằng mình có khả năng cạnh tranh với một trong những doanh nghiệp có giá trị nhất thế giới khi phát triển một loại chip mới dành riêng cho AI.

“Có điều gì đó không ổn.” Đó là cảm giác của Jonathan Ross trong một buổi thuyết trình tại Oslo, Na Uy vào tháng 2.2024. Khi ấy, CEO 42 tuổi của startup AI có tên Groq đang giới thiệu với các thành viên nghị viện Na Uy và các giám đốc công nghệ về một sản phẩm mà Jonathan Ross kỳ vọng sẽ tạo sức bật cho công ty đang gặp khó khăn của ông: chatbot AI có thể trả lời câu hỏi gần như ngay lập tức, nhanh hơn cả khả năng đọc của con người.

Nhưng rồi, vì lý do nào đó mà chatbot AI lại hoạt động không như mong đợi. Sự cố ngoài ý muốn khiến Jonathan Ross cảm thấy lo lắng, vì ông đang giới thiệu công nghệ này để quảng bá cho trung tâm dữ liệu mới ở châu Âu sử dụng chip AI chuyên dụng có hiệu suất phản hồi cực nhanh do Groq phát triển. “Tôi đã bị phân tâm do phải kiểm tra số liệu, và mọi người không hiểu vì sao tôi lại như vậy,” Jonathan Ross cho biết.

Nguyên nhân là do sự gia tăng đột biến của lượng người dùng mới. Một ngày trước buổi thuyết trình của Jonathan Ross tại Oslo, một nhà phát triển công nghệ đã hào hứng chia sẻ bài viết khen ngợi “chatbot AI có khả năng phản hồi nhanh như chớp.” Điều này đã dẫn đến lượng người dùng mới đăng ký trải nghiệm trực tuyến tăng vọt, khiến hệ thống máy chủ của Groq rơi vào tình trạng quá tải. Đó là sự cố không mong muốn, nhưng lại thể hiện sự quan tâm dành cho sản phẩm của Groq.

Jonathan Ross đặt tên công ty của mình theo tiếng Martian có nghĩa là “hiểu bằng sự đồng cảm” (Martian là ngôn ngữ sao Hỏa trong bộ phim khoa học viễn tưởng kinh điển Stranger in a Strange Land). Elon Musk cũng thích từ này và đặt tên cho chatbot AI của mình là Grok.

Khi thành lập Groq vào năm 2016, mục tiêu của Jonathan Ross là phát triển chip AI dành riêng cho “phương pháp suy luận” (Inference), một phần quy trình của công nghệ AI áp dụng mô hình và thuật toán đã được huấn luyện để bắt chước cách suy luận của con người cho các tình huống xử lý mới. Đó là công nghệ giúp điện thoại thông minh nhận ra chú chó thuộc giống Corgi trong bức ảnh chưa từng nhìn thấy trước đó, hoặc hỗ trợ trình tạo ảnh đưa ra hình giáo hoàng Francis mặc chiếc áo khoác thương hiệu Balenciaga. Inference đòi hỏi ít sức mạnh tính toán hơn so với việc đào tạo nhiều mô hình AI ngay từ đầu.

Trước thời điểm OpenAI ra mắt ChatGPT vào cuối năm 2022 và tạo nên cơn sốt công nghệ AI trên toàn thế giới, nhu cầu dành cho phương pháp Inference có khả năng vận hành siêu nhanh còn rất hạn chế. Và điều đó đã đẩy Groq vào tình thế khó khăn. “Không ít lần Groq đứng trước nguy cơ phá sản. Có lẽ chúng tôi đã thành lập công ty quá sớm,” Jonathan Ross trả lời phỏng vấn trong phòng nghiên cứu bán dẫn của Groq ở San Jose, California. Ông nhớ lại giai đoạn khó khăn vào năm 2019, khi Groq chỉ còn đủ nguồn tài chính để duy trì hoạt động trong một tháng.

Giờ đây, khi nhu cầu dành cho sức mạnh tính toán để phát triển và vận hành các mô hình AI tăng cao, lớn đến mức dẫn tới tình trạng thiếu hụt điện trên toàn thế giới, Groq đang có lợi thế để tạo ra tầm ảnh hưởng đáng kể trên thị trường hoặc trở thành mục tiêu mua lại tiềm năng của các doanh nghiệp lớn về công nghệ chip. Nhu cầu dành cho sức mạnh tính toán hiện vô cùng lớn, dẫn đến tăng vốn hóa thị trường của Nvidia lên ba ngàn tỉ đô la Mỹ với doanh thu đạt 60,9 tỉ đô la Mỹ.

So với Nvidia, Groq chỉ là doanh nghiệp có quy mô khiêm tốn. Theo thông tin hồ sơ tài chính Forbes có được, doanh thu của Groq trong năm 2023 đạt 3,4 triệu đô la Mỹ và công ty báo lỗ 88,3 triệu đô la Mỹ. Nhưng khi chip AI thu hút nhiều sự quan tâm hơn, Groq đã đưa ra dự báo lạc quan rằng doanh thu có thể chạm ngưỡng 100 triệu đô la Mỹ trong năm 2024. Tuy nhiên, công ty lại vấp phải nghi ngờ về khả năng hoàn thành mục tiêu này. Groq từ chối bình luận về dự báo kết quả tài chính.

Các công ty AI chiếm 16 vị trí trong danh sách Cloud 100 thường niên lần thứ chín của Forbes về các công ty điện toán đám mây tư nhân hàng đầu thế giới, so với con số tám công ty của năm ngoái và không có vị trí nào vào năm năm trước. Lĩnh vực chip AI được dự báo có quy mô 1.100 tỉ đô la Mỹ vào năm 2027, và Jonathan Ross nhìn thấy cơ hội để Groq tóm lấy “miếng bánh” thị trường nơi Nvidia đang thống trị với 80% thị phần. Công ty hiện thực hóa điều đó bằng cách tập trung vào Inference.

Theo Công ty nghiên cứu thị trường IDC, thị trường chip AI Inference sẽ có giá trị khoảng 39 tỉ đô la Mỹ trong năm 2024 và tăng lên 60,7 tỉ đô la Mỹ trong bốn năm tiếp theo. “Sức mạnh tính toán giống như một loại nhiên liệu mới,” Jonathan Ross cho biết.

“Chip của Groq hoạt động thực sự hiệu quả.”

—Yann LeCun, giám đốc khoa học tại Meta.

Các công ty như Groq lạc quan về cơ hội cạnh tranh trên thị trường này, vì chip của Nvidia vốn ban đầu không được phát triển cho tác vụ AI. Khi được CEO Jensen Huang (Hoàng Nhân Huân) công bố lần đầu vào năm 1999, bộ vi xử lý đồ họa (GPU) của Nvidia được thiết kế cho mục đích kết xuất đồ họa trong các trò chơi điện tử. Và GPU này chỉ tình cờ trở thành chip phù hợp nhất để đào tạo AI. Do đó, cơ hội vẫn mở ra cho Groq và thế hệ startup phát triển chip AI tiếp theo, bao gồm Cerebras (vốn hóa thị trường bốn tỉ đô la Mỹ) và SambaNova (5,1 tỉ đô la Mỹ). “Nếu thiết kế chip cho AI ngay từ ban đầu, không ai phát triển GPU cả,” Andrew Feldman, CEO của Cerebras, cho biết.

Không chỉ các startup, Amazon và Microsoft cũng phát triển chip AI của riêng mình với tham vọng giành lấy vị thế dẫn đầu của Nvidia. Groq tự tin về khả năng cạnh tranh của mình khi chip do công ty phát triển, được gọi là LPU (Language Processing Unit – bộ xử lý ngôn ngữ), hoạt động rất nhanh. Lúc thuyết trình trước các nhà đầu tư, Groq cho biết LPU hoạt động nhanh gấp bốn lần, chi phí thấp hơn năm lần và tiêu thụ năng lượng hiệu quả gấp ba lần so với GPU của Nvidia khi được dùng cho phương pháp Inference. Nvidia từ chối đưa ra bình luận về tuyên bố này.

“Chip của Groq có khả năng suy luận tốt hơn rất nhiều so với các giải pháp khác trên thị trường,” Aemish Shah, đồng sáng lập General Global Capital, quỹ đã rót vốn cho nhiều vòng huy động tài chính của Groq, cho biết.

Groq bắt đầu cung cấp chip AI chuyên dụng do công ty sản xuất từ năm 2022, đến nay đã có thêm các khách hàng đáng chú ý, ví dụ như Argonne National Labs, cơ sở nghiên cứu thuộc Chính phủ Mỹ thành lập từ dự án Manhattan (nghiên cứu và phát triển bom hạt nhân).

Argonne National Labs dùng chip của Groq trong nghiên cứu phản ứng tổng hợp hạt nhân, dạng năng lượng được phóng thích khi mô phỏng lại quá trình phản ứng ở lõi mặt trời. Aramco Digital, đơn vị công nghệ thuộc doanh nghiệp dầu khí lớn nhất thế giới Saudi Aramco ở Saudi Arabia, cũng hợp tác với Groq để sử dụng chip của công ty.

Vào tháng 3.2024, Groq ra mắt GroqCloud, nền tảng cho phép các nhà phát triển thuê chip AI mà không cần phải mua trực tiếp. Để thu hút những nhà phát triển, ban đầu Groq cung cấp GroqCloud miễn phí và ghi nhận 70 ngàn nhà phát triển đăng ký sử dụng trong tháng đầu tiên hoạt động. Tính đến thời điểm hiện tại, GroqCloud có 350 ngàn tài khoản và con số này vẫn tiếp tục tăng lên.

Vào ngày 30.6.2024, Groq bắt đầu tính phí cho GroqCloud và tuyển dụng Stuart Pann, cựu giám đốc điều hành tại Intel, vào vị trí COO để giúp công ty đẩy mạnh doanh thu và mở rộng quy mô hoạt động. Stuart Pann lạc quan về khả năng tăng trưởng của Groq, khi hơn 25% số lượng khách hàng sẵn sàng trả phí để có thêm sức mạnh tính toán.

“Chip của Groq hoạt động thực sự hiệu quả,” Yann LeCun, giám đốc khoa học tại Meta và từng là giáo sư dạy chuyên ngành khoa học máy tính cho Jonathan Ross ở Đại học New York, cảm thán. Gần đây, Yann LeCun đã gia nhập Groq trong vai trò cố vấn kỹ thuật. Trong tháng 7.2024, Mark Zuckerberg công bố Groq sẽ trở thành đối tác cung cấp chip vận hành Inference cho mô hình AI mới của Meta, Llama 3.1. Vị CEO của Meta đánh giá Groq là cái tên tiên phong về công nghệ này.

Kinh nghiệm trong lĩnh vực chip được Jonathan Ross tích lũy từ khoảng thời gian làm việc tại Google, nơi ông từng tham gia đội ngũ phát triển bộ xử lý Tensor (TPU) dành riêng cho các tác vụ máy học (machine learning). Năm 2016, Jonathan Ross rời tập đoàn công nghệ Mỹ để thành lập Groq cùng người đồng nghiệp Doug Wightman, một kỹ sư khác tại Google. Doug Wightman trở thành CEO đầu tiên của Groq.

Cũng trong năm đó, Groq đã huy động thành công 10 triệu đô la Mỹ từ vòng gọi vốn do quỹ đầu tư mạo hiểm Social Capital dẫn dắt. Tuy vậy, công ty đã gặp khó khăn trong việc tìm kiếm nhà đầu tư mới sau lần huy động tài chính này. Vài năm sau, Doug Wightman rời công ty. Ông cũng không phản hồi yêu cầu trả lời phỏng vấn.

Groq vẫn vấp phải nhiều hoài nghi. Một nhà đầu tư mạo hiểm từng quyết định không rót vốn trong vòng Series D của Groq đánh giá công ty có ý tưởng kinh doanh mới lạ, song nghi ngờ khả năng duy trì và bảo vệ lợi thế cạnh tranh về lâu dài.

“Không dễ để các giải pháp khác có thể thay thế công nghệ của Nvidia,” Mitesh Agrawal, giám đốc phụ trách bộ phận điện toán đám mây cho startup phát triển hạ tầng AI quy mô 1,5 tỉ đô la Mỹ Lambda Labs, nhận định. Mitesh Agrawal cho biết Lambda không có kế hoạch sử dụng Groq hay bất kỳ chip chuyên dụng nào khác cho dịch vụ đám mây của công ty này. Số khác đặt câu hỏi liệu Groq có hiệu quả về mặt chi phí khi sử dụng với số lượng lớn hay không.

Jonathan Ross thừa nhận sẽ rất khó để Groq cạnh tranh với Nvidia. “Chúng tôi giống như ‘tân binh’ rất tiềm năng nhưng vẫn còn một chặng đường dài để tiến tới sánh ngang với Nvidia. Thị trường đang hướng sự chú ý vào chúng tôi, và họ muốn biết động thái tiếp theo của công ty sẽ là gì,” ông cho biết.

Trong một cuộc phỏng vấn độc quyền với Forbes vào ngày 8.5.2024, Groq cho biết đã huy động đến 640 triệu đô la Mỹ từ vòng gọi vốn Series D và nhận về mức định giá 2,8 tỉ đô la Mỹ, tăng từ 1,1 tỉ đô la Mỹ vào năm 2021. Vòng Series D do BlackRock Private Equity Partners dẫn dắt, với sự tham gia từ Cisco Investments và Samsung Catalyst Fund, quỹ đầu tư mạo hiểm thuộc Tập đoàn Samsung tập trung rót vốn vào các lĩnh vực hạ tầng và AI.

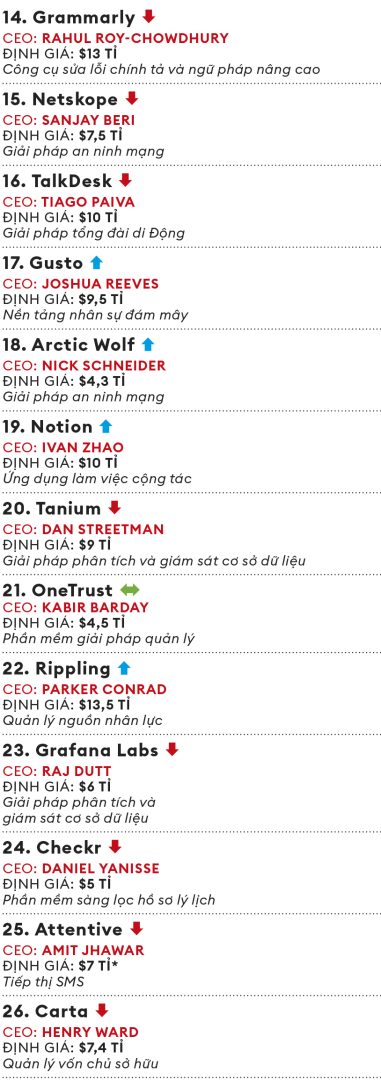

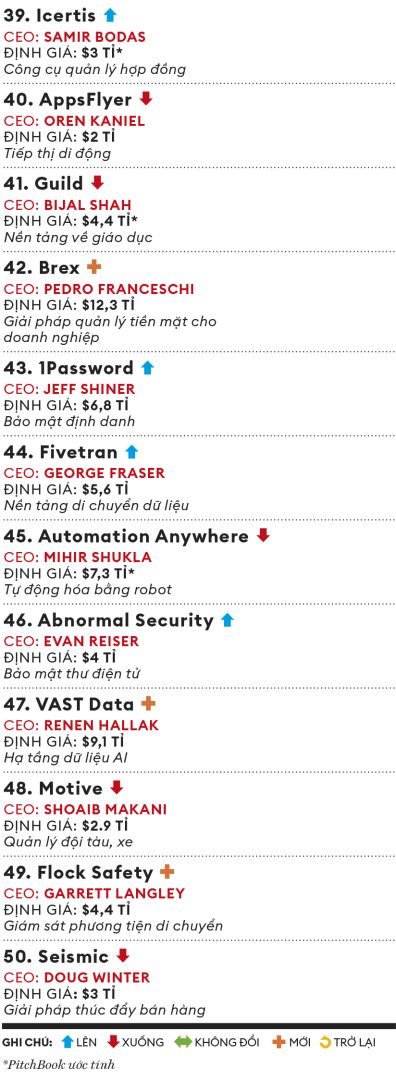

Thị trường IPO trong lĩnh vực công nghệ đang trong tình trạng trì trệ, vì vậy những cái tên quen thuộc vẫn thống trị vị trí đầu bảng danh sách thường niên lần thứ chín của Forbes về các công ty điện toán đám mây tư nhân hàng đầu thế giới, được chúng tôi xuất bản với sự hợp tác của Bessemer Venture Partners và Salesforce Ventures. Không có gì ngạc nhiên khi các công ty AI như Anthropic (xếp thứ năm, tăng từ vị trí thứ 73) và Scale AI (xếp thứ bảy, tăng 26 bậc) nằm trong số những công ty có bước tiến lớn nhất trong năm nay, và những công ty AI đột phá như Mistral (hạng 92), Runway (hạng 94) và Cohere (xếp hạng 99) ra mắt. Ngoài ra còn có Ramp (vị trí 37) và Brex (vị trí 42) cạnh tranh quyết liệt trong số các công ty khởi nghiệp công nghệ tài chính đang nổi bật. Dưới đây là 50 công ty hàng đầu trong danh sách. Để xem danh sách đầy đủ, hồ sơ công ty và phương pháp, vui lòng truy cập: forbes.com/lists/cloud100.

THÀNH VIÊN MỚI VÀ ĐÁNG CHÚ Ý

Sau khi bán công ty đầu tiên Paribus, nền tảng theo dõi giá vé máy bay trực tuyến, cho Capital One vào năm 2016, Eric Glyman đã chuyển sang lĩnh vực fintech và đồng sáng lập startup lấy tên Ramp sau đó ba năm. Đặt tại New York, Mỹ, Ramp cung cấp thẻ tín dụng số có hạn mức được tùy chỉnh và cung cấp những tính năng của ngân hàng cho các công ty công nghệ như Shopify, Discord và Glossier. Ramp giúp các doanh nghiệp quản lý tiền hiệu quả hơn để tiết kiệm chi phí hoạt động.

“Một điều tuyệt vời của thẻ tín dụng là ta nhận lại một đô la Mỹ cho mỗi 100 đô la Mỹ đã bỏ ra. Nhưng cách hiệu quả nhất để tiết kiệm chi phí là không sử dụng số tiền đó ngay từ đầu,” Eric Glyman cho biết.

Mike Intrator, CEO CoreWeave, không lường trước được rằng sự phát triển mạnh mẽ của công nghệ AI đã thúc đẩy nhu cầu rất lớn dành cho dịch vụ điện toán đám mây mà công ty ông cung cấp. “Nhu cầu lớn đến mức hệ thống của chúng tôi bị quá tải và công ty vẫn khó đáp ứng kịp mặc dù đã đầu tư thêm chip,” Mike Intrator cho biết.

Trong một năm qua, công ty có trụ sở tại Roseland, New Jersey (Mỹ) đã huy động tổng cộng 12 tỉ đô la Mỹ thông qua khoản vay và vốn đầu tư mạo hiểm từ các nhà đầu tư như Blackstone, Coatue để đáp ứng nhu cầu lớn như vậy. Lần huy động tài chính này đã định giá CoreWeave ở mức 19 tỉ đô la Mỹ. Nhân tố giúp CoreWeave phát triển nhanh chóng đến từ lượng lớn GPU mà công ty đã mua từ Nvidia để khai thác tiền mã hóa vào năm 2017.

Năm 2019, CoreWeave chuyển hướng sang cho các startup thuê những GPU này. Vào năm 2023, việc kinh doanh của CoreWeave phát triển mạnh mẽ, và đang vận hành hàng chục trung tâm dữ liệu ở khắp nước Mỹ. Hiện tại, CoreWeave tập trung mở rộng sang các thị trường Tây Ban Nha, Na Uy và Thụy Điển, cũng như cân nhắc IPO vào năm 2025.

Anthropic nổi lên như một “kẻ thách thức” dành cho OpenAI, công ty đang dẫn đầu thị trường AI hiện nay. Hồi tháng 6.2024, công ty AI quy mô 18 tỉ đô la Mỹ đã ra mắt mô hình ngôn ngữ lớn (LLM) có tên gọi Claude 3.5 Sonnet.

Đồng sáng lập kiêm CEO Daro Amodei tuyên bố mô hình này vượt trội hơn tất cả đối thủ cạnh tranh. Claude 3.5 Sonnet đã được dùng cho nhiều tác vụ khác nhau như lập trình ứng dụng và xử lý tài liệu pháp lý. Dario Amodei cũng đặc biệt quan tâm đến lĩnh vực chăm sóc sức khỏe. Pfizer và trung tâm ung thư Dana-Farber là những khách hàng đầu tiên, bên cạnh DeepScribe, sử dụng Claude 3.5 Sonnet trong việc hỗ trợ các bác sĩ sắp xếp lịch gặp bệnh nhân.

“Khi trở nên thông minh hơn, các mô hình sẽ được ứng dụng nhiều hơn nữa vào những hoạt động, chức năng cốt lõi trong lĩnh vực chăm sóc sức khỏe,” Daro Amodei cho biết.

Không góp mặt trong danh sách năm 2023, nền tảng thiết kế Figma đã quay trở lại với vị trí thứ 12. Figma đã hủy bỏ thương vụ bán lại cho Abode trị giá 20 tỉ đô la Mỹ vào tháng 12.2023 do những lo ngại về vi phạm luật chống độc quyền. Vào tháng 6.2024, Figma tổ chức một sự kiện trong khuôn khổ hội nghị người dùng thường niên Config của mình. Tại sự kiện, 10 ngàn người tham dự chứng kiến CEO Dylan Field công bố Figma AI, công cụ giúp phần mềm của Figma dễ dàng sử dụng hơn nữa cho những người không quen với các yếu tố thiết kế như họa tiết và kiểu chữ. Tuy nhiên, việc ra mắt sản phẩm mới lại khiến công ty gặp rắc rối.

Theo đó, một bài đăng trên nền tảng X đã cáo buộc Figma AI, công cụ cho phép người dùng tạo ra bản thiết kế bằng mã lệnh, lấy tài nguyên từ những ứng dụng khác. Dylan Field phủ nhận cáo buộc này nhưng quyết định tạm dừng triển khai. “Tôi cảm thấy thất vọng khi mọi việc diễn ra không như ý muốn,” Dylan Field chia sẻ trên trang cá nhân.

Biên dịch: Quỳnh Anh

Theo forbes.baovanhoa.vn (https://forbes.baovanhoa.vn/tham-vong-to-lon)

Xem thêm

5 tháng trước

Kiến tạo di sản thương hiệu trong kỷ nguyên bất định4 năm trước

Vimeo và hành trình trở thành “người chiếm sóng”1 năm trước

IPO ở Đông Nam Á sẽ phục hồi trong năm 2025?1 năm trước

Startup dược phẩm Xtalpi IPO tại Hong Kong