Patronus AI phát triển công nghệ giúp cải thiện mô hình AI

Patronus AI cho biết Lynx không chỉ phát hiện lỗi sai từ mô hình AI, mà còn giải thích vì sao phản hồi lại thiếu chính xác.

Mô hình AI tạo sinh có thể mang đến những phản hồi tuyệt vời cho nhiều mục đích sử dụng khác nhau, nhưng công nghệ này vẫn tiềm ẩn rủi ro mắc phải sai lầm. Do đó, Patronus AI, công ty mới nổi về trí tuệ nhân tạo đứng sau mô hình AI mã nguồn mở mới có tên gọi Lynx muốn khắc phục vấn đề này. Lynx do Patronus AI phát triển hứa hẹn hoạt động nhanh, tin cậy hơn với mức phí thấp hơn để hạn chế việc công cụ AI đưa ra câu trả lời sai cho người dùng.

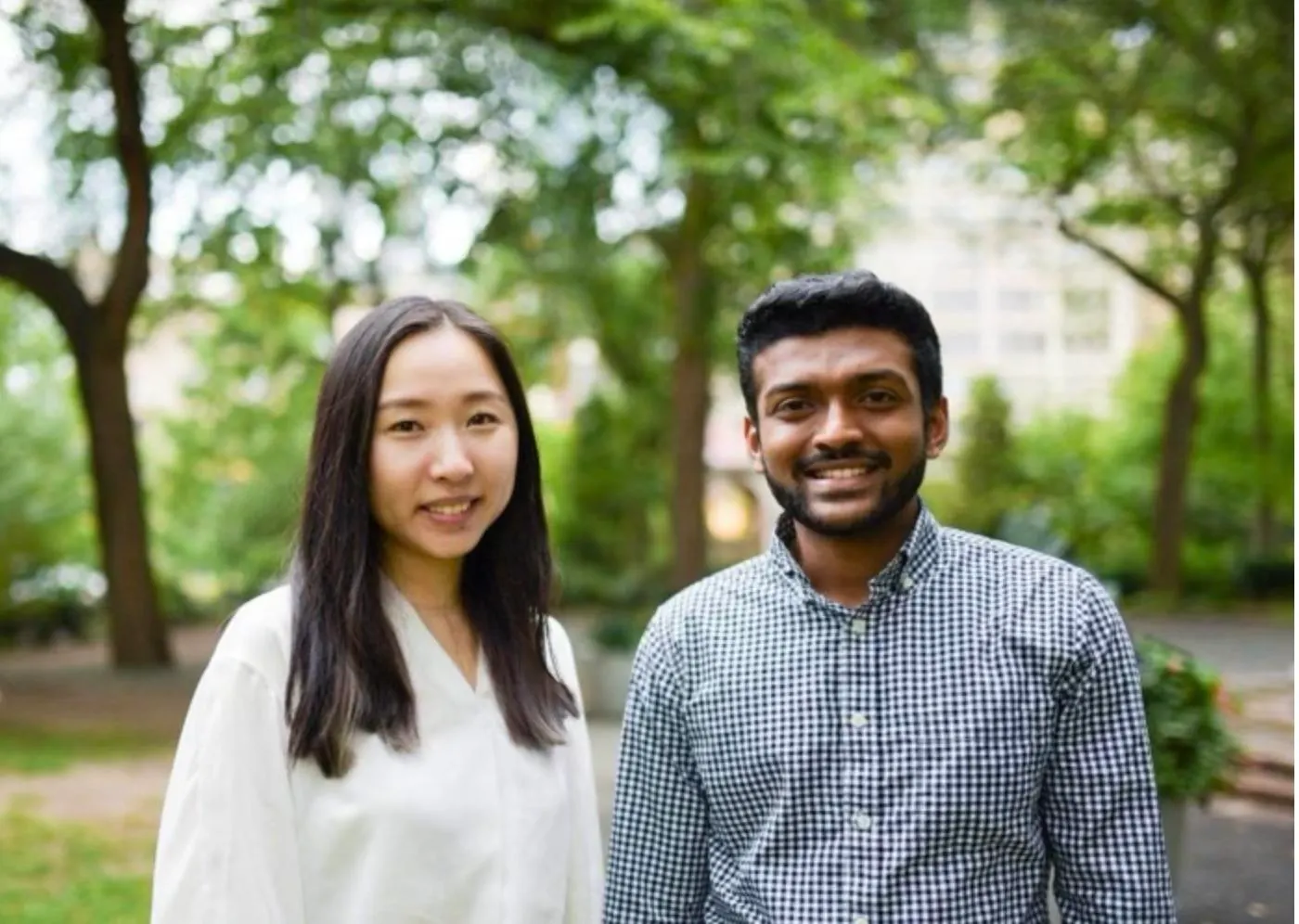

Hai nhà sáng lập công ty Anand Kannappan và Rebecca Qian, những nhà nghiên cứu từng làm việc tại Meta AI, cho biết Lynx làm tốt hơn những mô hình AI hàng đầu hiện nay, như ChatGPT của OpenAI và Claude 3 từ Anthropic, về mặt phát hiện thông tin thiếu chính xác. Để làm được như vậy, Patronus AI đã tinh chỉnh mô hình AI tân tiến nhất của Meta, Llama 3 bằng cách cho công cụ này tiếp nhận 2.400 mẫu câu trả lời sai khác nhau. Llama 3 qua đó sẽ học cách đưa ra những thông tin chính xác hơn.

Trước khi thành lập Patronus AI vào tháng 9.2023, Anand Kannappan và Rebecca Qian từng thảo luận với các giám đốc từ 60 công ty khác nhau, ghi nhận họ đều có mối lo ngại lớn nhất khi triển khai sản phẩm AI là vấp phải những sự chỉ trích và góc nhìn tiêu cực. Anand Kannappan kỳ vọng Lynx có thể giảm đi nỗi lo sợ như vậy.

Theo anh, Lynx đóng vai trò “chỉ dẫn và định hướng” cho những mô hình AI khác đưa ra phản hồi chính xác hơn. Mục tiêu mà công ty hướng tới là khách hàng của Patronus AI, những công ty ra mắt mô hình AI, có thể dùng Lynx để sửa lỗi sai trong quá trình phát triển thay vì chỉ khắc phục sau khi đã ra thị trường.

“Hỗ trợ giám sát mô hình AI khác là một trong những lý do để Rebecca và tôi thành lập công ty này. Mặc dù mô hình AI có khả năng xử lý thông tin nhanh hơn, nhưng công nghệ vẫn cần đến sự giám sát từ con người. Và cách duy nhất để ta có thể làm điều đó là tạo ra mô hình AI có khả năng đánh giá mô hình khác,” Anand Kannappan cho biết.

Anand Kannappan cho biết điều này khác với quy trình thông thường khi mô hình AI trải qua việc kiểm thử phần mềm trước khi cung cấp ra thị trường, bao gồm nhiều kỹ thuật khác nhau. Một trong số này là “red teaming,” kỹ thuật mô phỏng lại những cuộc tấn công vào mô hình AI để khai thác lỗ hổng có thể khiến công nghệ gặp lỗi sai.

Tại những công ty khác, đội ngũ phát triển dùng mô hình như GPT-4 để ghi nhận lỗi sai. Nhưng Anand Kannappan cho rằng cách làm đó lại như “dùng chính GPT-4 đánh giá chính mô hình này vậy.” Anh cho rằng đó là vấn đề, vì các mô hình như GPT-4 vốn không được tạo ra để “bắt” lỗi sai. Trong khi đó, Lynx lại được phát triển với mục đích nhận diện phản hồi không chính xác từ việc phân tích nội dung, Rebecca Qian cho biết.

“Chúng tôi đưa ra ví dụ về những câu trả lời sai từ mô hình AI, cùng với thống kê tài chính cụ thể hoặc trích dẫn y tế để cho thấy vì sao phản hồi không chính xác,” Rebecca Qian chia sẻ. Hướng tiếp cận này mang lại hiệu quả hơn vì Lynx tiếp nhận thêm ngữ cảnh để nâng cao khả năng phát triển lỗi sai tương tự.

Patronus AI cũng ra mắt sản phẩm mới HaluBench, công cụ đánh giá khả năng phát hiện lỗi sai của các mô hình AI, đặc biệt trong những lĩnh vực pháp lý, tài chính và y khoa.

Theo HaluBench, Lynx đạt khoảng 88% điểm đánh giá, chưa đến mức tốt nhất nhưng theo Anand Kannappan vẫn cao hơn so với những mô hình khác.

Hồi tháng 3.2024, Patronus AI ra mắt thêm Copyright Catcher, công cụ có khả năng phát hiện khi nào các mô hình AI phổ biến như GPT-4, Claude 2 và Mixtral (Mistral AI) tạo ra nội dung vi phạm bản quyền. Copyright Catcher đã ghi nhận trường hợp các mô hình AI sao chép toàn bộ nội dung trong những quyển sách như Becoming của Michelle Obama và The Fault in Our Stars của John Green.

Patronus AI cũng phát triển những công cụ khác dùng để đánh giá khả năng vận hành trong các lĩnh vực cụ thể.

Ví dụ, FinanceBench đánh giá mô hình ngôn ngữ lớn (LLM) đưa ra câu trả lời hiệu quả ra sao đối với câu hỏi về tài chính, Enterprise PII hỗ trợ các công ty xác định xem liệu mô hình AI có vô tình để lộ thông tin mật hay không. Và Simple Safety, công cụ đánh giá rủi ro an toàn như tạo ra phản hồi liên quan đến những yếu tố tiêu cực.

Toàn bộ những sản phẩm trên đều hướng tới sứ mệnh chung của Patronus AI: Đảm bảo rằng các mô hình AI không tạo ra phản hồi thiếu chính xác. “Khi cho ra kết quả sai, các mô hình sẽ tiếp tục đưa ra phản hồi có vẻ hợp lý nhưng lại không chính xác. Hệ quả là người dùng tiếp nhận thông tin sai lệch,” Rebecca Qian cho biết.

Biên dịch: Minh Tuấn

Theo forbes.baovanhoa.vn (https://forbes.baovanhoa.vn/patronus-ai-phat-trien-cong-nghe-giup-cai-thien-mo-hinh-ai)